面向开发者的 NVIDIA NeMo Customizer

NVIDIA NeMo™ Customizer 是一个高性能、可扩展的微服务,旨在简化生成式 AI 模型的微调与对齐,以便构建特定领域的 AI 智能体。通过以 API 为核心的设计,该微服务支持多种常用的定制与后训练技术,包括低秩适配(LoRA)、全监督微调(SFT)、直接偏好优化(DPO)以及群体相对策略优化(GRPO),并持续集成最新的定制化与对齐方法。

若需要更广泛的强化学习支持,包括先进的 RL 算法和大规模后训练,可探索作为 NeMo 框架一部分的开源 NeMo RL 库。

NeMo Customizer 以及其他 NeMo 微服务,使开发者能够创建数据飞轮不断优化生成式 AI 智能体,增强最终用户的整体体验。

查看 NVIDIA NeMo Customizer 的实际应用

了解 NeMo Customizer 如何帮助开发者使用特定领域的数据微调大语言模型,从而为客户支持、医疗健康见解、企业自动化和许多其他应用等任务创建定制的 AI 智能体。

NVIDIA NeMo Customizer 的工作原理

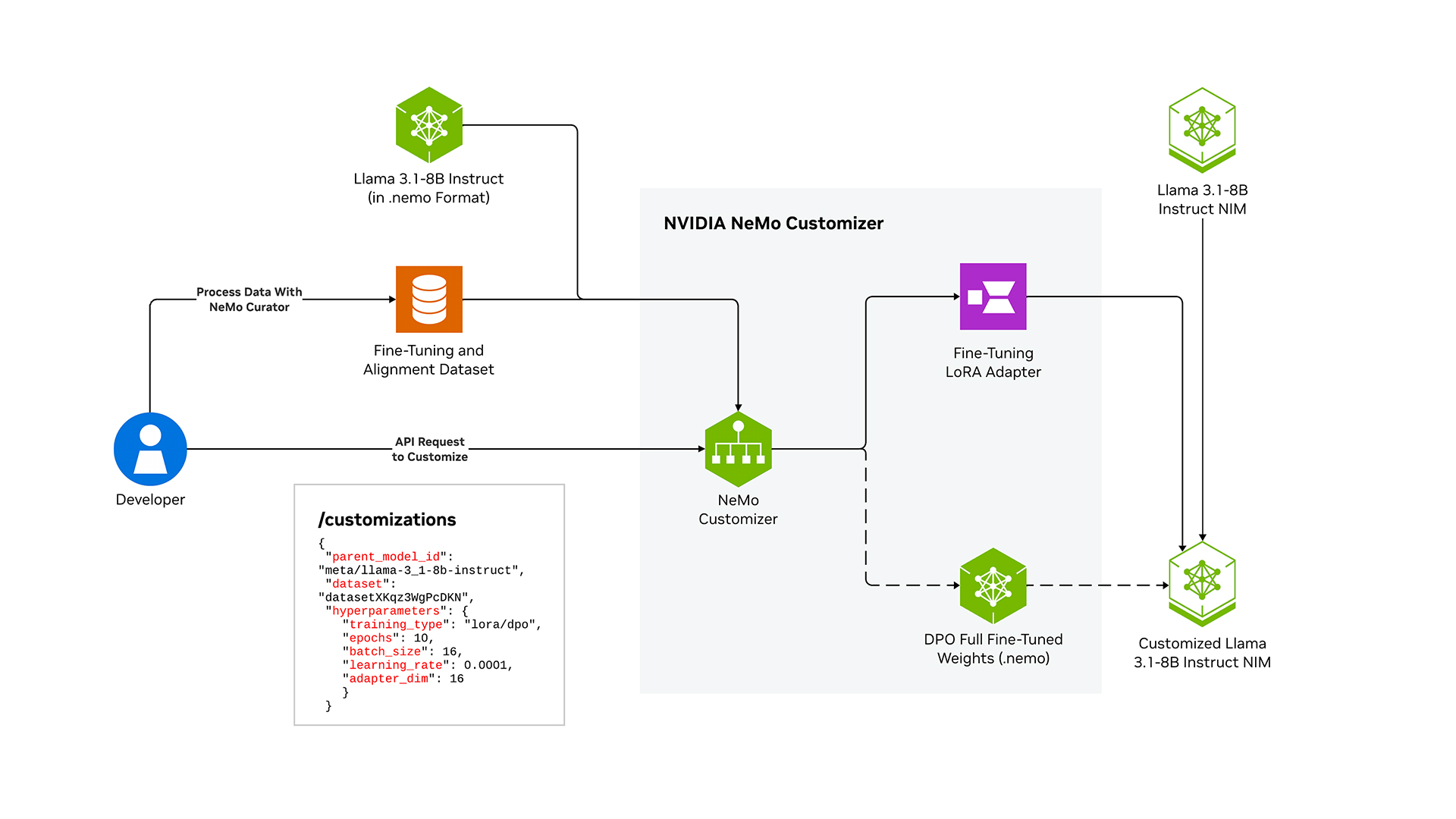

NeMo Customizer 提供易于使用的 API,可以让用户自定义生成式 AI 模型。只需在 API 请求体中提供数据集、模型名称、超参数和定制类型,NeMo Customizer 就会启动模型微调任务,最终生成定制化模型版本。

下方的架构图展示了使用 NeMo Customizer 的流程,它支持无缝启动多个定制任务。在上述场景中,您可以利用 NeMo Customizer 创建两个定制化流程:一个用于微调,另一个用于对齐调优。这些输出与 NVIDIA NIM™结合,可以部署针对具体应用需求的定制模型。

NeMo Customizer 目前支持用于强化学习的 DPO 和 GRPO 技术。若需更广泛的强化学习支持,包括高级算法和大规模后训练,请探索作为 NeMo 框架一部分的开源 NeMo RL 库。

如何开始使用 NVIDIA NeMo Customizer

开始使用 NeMo Customizer,可以简化大型语言模型(LLM)在特定领域用例中的微调和对齐。如果需要更广泛的强化学习支持,包括高级算法和大规模后训练,可以探索作为 NeMo 框架一部分的开源 NeMo RL 库。

性能

NeMo Customizer 使用多种并行技术来缩短大型模型的训练时间,并支持多 GPU 和多节点基础设施。这些方法协同工作,可增强训练过程,确保优化资源利用并提高训练性能。

使用 NeMo Customizer 体验定制速度提升 1.8 倍

该基准测试表示在一个 8xH100 80G SXM 上使用序列打包 (封装尺寸为 4096,封装效率为 0.9958) 自定义 Llama-3 -8B。

开:使用 NeMo Customizer 定制。

关闭:使用领先的市场替代方案进行定制。

入门套件

访问各种用例的教程、最佳实践和文档,开始使用 NeMo Customizer 调整生成式 AI 模型。

NVIDIA NeMo Customizer 学习资源库

更多资源

AI 伦理

NVIDIA 的平台和应用框架使开发者能够构建各种 AI 应用。在选择或创建要部署的模型时,请考虑潜在的算法偏差。与模型的开发者合作,确保模型满足相关行业和用例的要求;提供必要的说明和文档以了解错误率、置信区间和结果;并确保模型在符合预期条件和方式的情况下使用。