NVIDIA Merlin NVTabular

NVIDIA Merlin™ 能够加快从提取、训练到部署 GPU 加速型推荐系统的整个工作流。Merlin NVTabular 是一个特征工程和预处理库,旨在有效操控 TB 级的推荐系统数据集,并显著缩短数据准备时间。它利用 RAPIDS™ cuDF 库提供高效的特征转换、预处理和高级抽象化功能,进而加速 GPU 上的计算。

立即下载并试用

Merlin NVTabular 核心特征

特征工程

NVTabular 的快速特征转换功能有助于缩短数据准备时间,并简化将推荐系统模型部署到生产环境的流程。借助 NVTabular 推荐系统专用 API,数据科学家和机器学习工程师能够快速处理各种规模的数据集,开展更多实验,并且不受 CPU 内存或 GPU 显存的制约。此外,它还支持多热分类和向量连续传递,进而简化特征工程。

运行示例加速 GPU 上的计算

NVTabular 利用 RAPIDS cuDF 库提供高级别抽象化功能,进而加速 GPU 上的计算。此外,NVTabular 通过 DASK CUDA 和 dask.distributed 支持多节点扩展和多 GPU,因此可以加速分布式并行处理。

探索更多内容Merlin NVTabular 性能

NVTabular 通过 RAPIDS cuDF、Dask 和 Dask_cuDF 支持多 GPU,因此可以实现高性能推荐系统专用工作流。在 CPU 集群处理 Criteo Terabyte 数据集中的 1.3 TB 数据方面,与基于 4 个节点、96 个 vCPU 内核的 Spark 相比,在 NVIDIA DGX™ A100 上使用 NVTabular 多 GPU 时,可使速度提升 95 倍;另外,若使用 8 个 NVIDIA A100 GPU,可使速度提升 5.3 倍,从使用 1 个 A100 时花费 10 分钟,缩短到使用 8 个 A100 时花费 1.9 分钟。

探索更多基准测试详细信息在多 GPU 上使用 NVTabular 实现加速

Merlin NVTabular 入门

所有 NVIDIA Merlin 组件都已作为开源项目发布在 GitHub 上。不过,若要使用这些组件,更方便的方法是使用 NVIDIA NGC 目录中的 Merlin NVTabular 容器。容器将软件应用、库、依赖项和运行时编译器打包在一个自包含环境中。这样一来,应用环境不仅可以实现可移植性、一致性、可重现性,而且可以独立于底层主机系统软件配置。

NGC 上的 Merlin NVTabular

Merlin 推理

借助容器,用户可将 NVTabular 工作流和 HugeCTR 或 TensorFlow 模型部署到 NVIDIA Triton™ 推理服务器,以用于生产。

Merlin NVTabular 资源

宣布推出 NVTabular 公测版

了解多 GPU 支持和数据加载程序如何加快推荐系统工作流。

NVIDIA Merlin

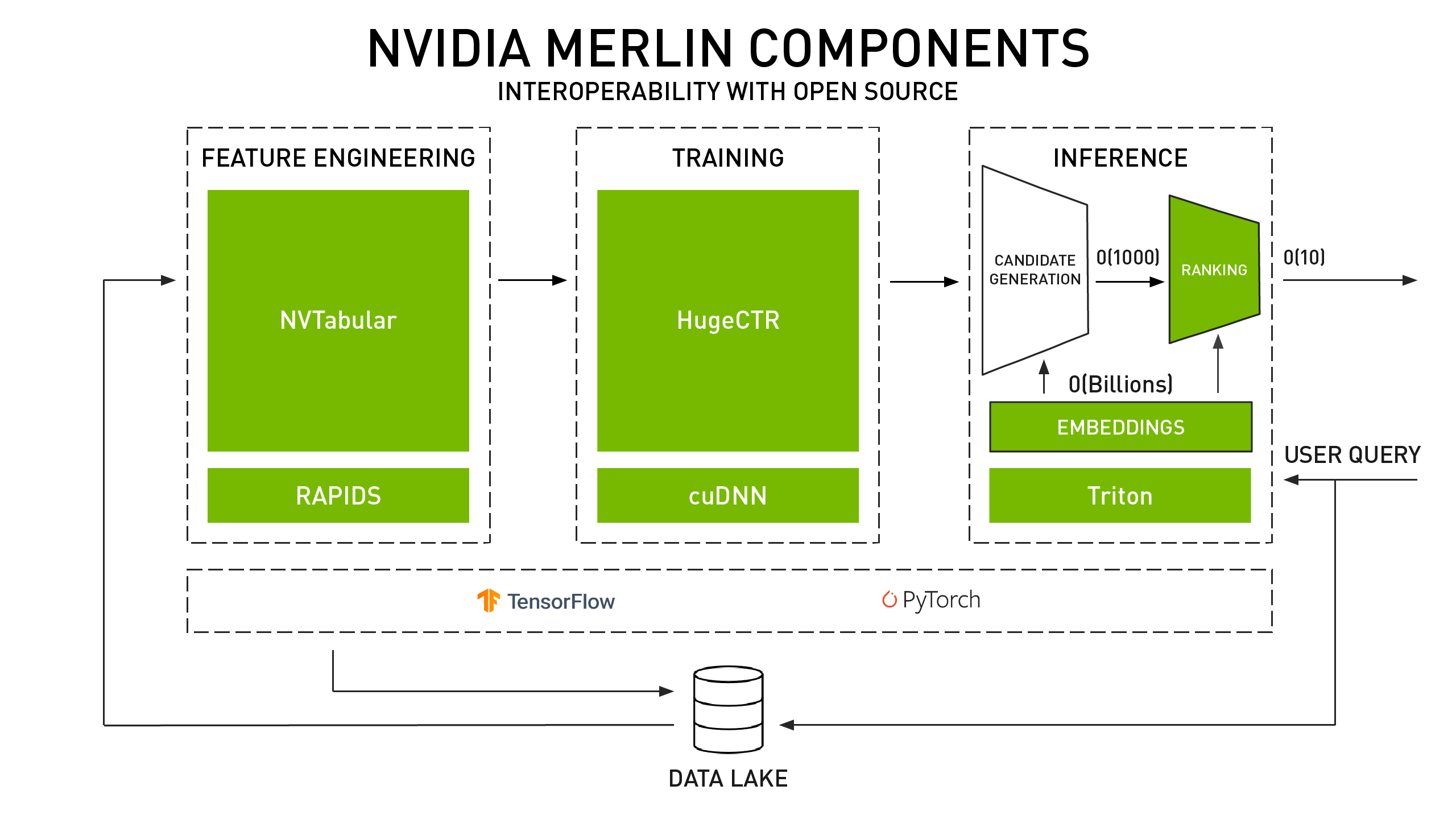

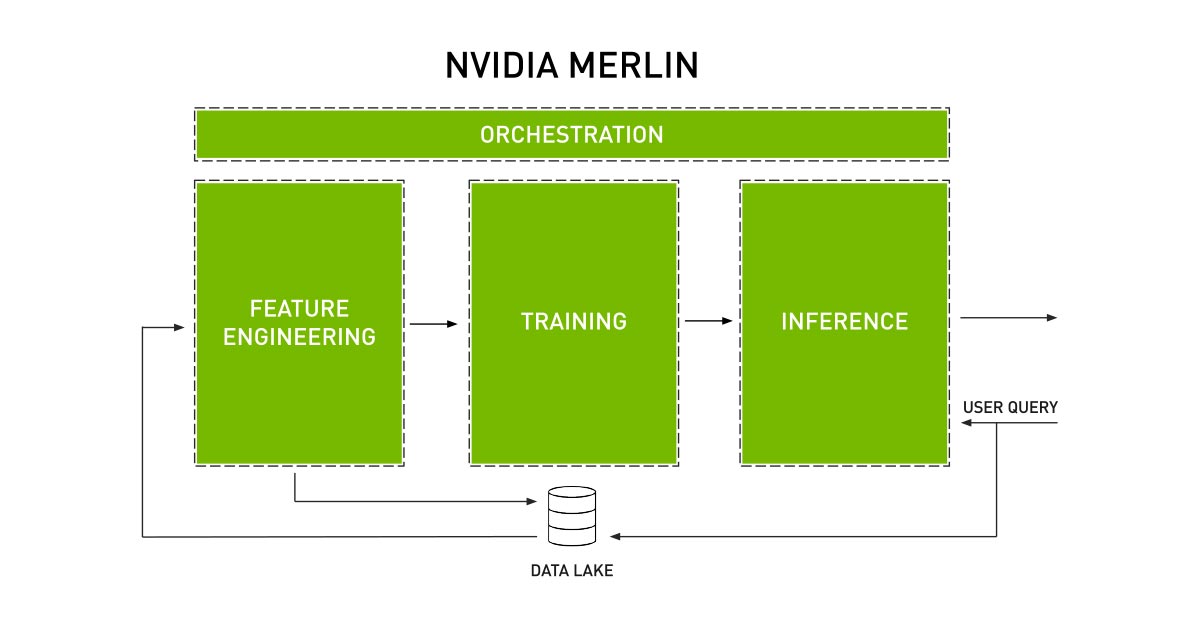

NVIDIA Merlin 由 Merlin 特征工程组件 (NVTabular)、Merlin 训练组件 (HugeCTR)、Merlin 推理组件(NVIDIA® TensorRT™ 和 Triton)以及 Merlin 参考应用组成。

行业最佳实践

了解推荐系统构建、部署和优化方面的新趋势和新见解,有效吸引用户并给业务价值带来积极影响。腾讯、美团、《纽约时报》、Magazine Luiza 等的最佳实践。

基于会话的推荐系统

NVIDIA Merlin 团队设计了 Transformers4Rec,以便帮助机器学习工程师和数据科学家了解 Transformer 并应用它们构建基于会话的序列式推荐系统。