最近

2026年 1月 15日

如何使用合成数据和强化学习训练 AI 智能体执行命令行任务

如果您的计算机智能体能够学习新的命令行界面(CLI),并且在无需编写文件或自由输入 shell 命令的情况下也能安全操作,该怎么办?

3 MIN READ

2026年 1月 14日

NVIDIA DLSS 4.5 推出超分辨率增强与全新动态多帧生成技术

带有多帧生成功能的 NVIDIA DLSS 4 已成为迄今为止普及速度最快的 NVIDIA 游戏技术。

2 MIN READ

2026年 1月 14日

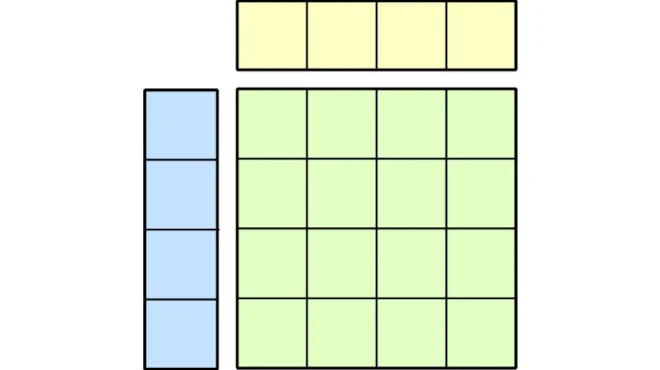

如何在 NVIDIA CUDA Tile 中编写高性能矩阵乘法

本博文是系列课程的一部分,旨在帮助开发者学习 NVIDIA CUDA Tile 编程,掌握构建高性能 GPU 内核的方法,

5 MIN READ

2026年 1月 13日

了解 NVIDIA cuOpt 如何通过原始启发式算法加速混合整数优化

NVIDIA cuOpt 是一款 GPU 加速的优化引擎,旨在为大规模复杂决策问题提供高效、高质量的解决方案。 混合整数规划(MIP)…

2 MIN READ

2026年 1月 12日

Hybrid-EP - 面向混合专家模型训练的通信优化方案

在大语言模型 (LLM) 训练领域,超大规模混合专家 (MoE) 模型训练中的EP通信一直是业内公认的难题。

4 MIN READ

2026年 1月 9日

构建支持本地化交互体验的 AI 产品目录系统

电子商务目录通常包含稀疏的产品数据、通用图像、基础标题和简短说明,这限制了产品的可发现性、用户参与度以及转化率。手动扩充难以规模化,

3 MIN READ

2026年 1月 9日

多智能体仓库 AI 命令层实现卓越运营和供应链智能

仓库的自动化程度从未如此之高,数据也从未如此丰富,运营要求同样日益提升,但许多仓库仍依赖于无法跟上需求的系统。吞吐量持续攀升,

2 MIN READ

2026年 1月 9日

重塑大模型内存:以上下文为训练数据,实现测试时学习

我们在新闻中不断看到拥有更大上下文窗口的大型语言模型(LLM),它们承诺能够同时查看完整的对话历史、大量书籍或多个代码库。然而,

1 MIN READ

增强现实/虚拟现实

2025年 10月 22日

使用 NVIDIA Nemotron 构建您自己的 Bash 计算机使用代理,只需一小时

如果您能够通过自然语言与计算机通信,让计算机在 Bash 终端中执行任务,而无需手动编写任何命令,该怎么办?

5 MIN READ

2025年 5月 18日

聚焦:Perfect Corp. 利用 NVIDIA TensorRT 和 NVENC 实现个性化的数字化美妆体验

增强现实 (AR) 和 AI 通过提供从虚拟试用到 AI 驱动的造型推荐等超个性化体验,正在彻底改变美妆和时尚行业。

1 MIN READ

2025年 5月 6日

借助 NVIDIA RTX PRO Blackwell 台式机 GPU 实现 Rivian 新一代XR 设计

对于不断突破 XR 界限的专业人士而言,打造身临其境的高保真体验始终充满挑战。在渲染大型数据集和驱动最新的超高分辨率高级 XR 头显设备时,

2 MIN READ

2025年 3月 5日

借助 NVIDIA Omniverse 将 AR 体验串流到 Apple iPad

最近在 MWC 巴塞罗那宣布 ,开发者现在可以将使用 NVIDIA Omniverse 构建的增强现实(AR)体验流式传输到 Apple…

1 MIN READ

2025年 2月 24日

在 NVIDIA 视频编解码器 SDK 13.0 中使用 MV-HEVC 启用立体和 3D 视图

NVIDIA 宣布在最新的 NVIDIA 视频编解码器 SDK 版本 13.0 中实施多视图高效视频编码 (MV-HEVC) 编码器。

2 MIN READ

2025年 1月 6日

利用 NVIDIA Omniverse 空间流,在 XR 中体验数字孪生技术

空间计算 体验正在转变我们与数据的交互方式,通过 扩展现实 (XR) 和 数字孪生 等技术连接物理和数字世界。

2 MIN READ

2024年 10月 24日

利用 NVIDIA Morpheus 加速警报分流和 LLM 代理强化安全运营中心

安全运营中心(SOC)分析师每天都会收到大量传入的安全警报。为了确保其组织的持续安全,他们的任务是仔细检查传入的噪音,分拣出误报,

1 MIN READ

2024年 10月 22日

多代理 AI 和 GPU 驱动的声音转文本技术创新

自动音频字幕 (Automated Audio Captioning) 任务的核心是从音频输入中生成自然语言描述。鉴于输入 (音频) 和输出…

2 MIN READ

数据科学

2025年 12月 17日

使用 NVIDIA cuDSS 解决大规模线性稀疏问题

随着芯片设计、制造和多物理场仿真复杂性的持续提升,在电子设计自动化(EDA)、

5 MIN READ

2025年 12月 17日

利用 Aether 项目将 Apache Spark 工作负载在 Amazon EMR 上大规模迁移至 GPU

数据是现代业务的燃料,但依赖基于 CPU 的 Apache Spark 管道 会带来高昂的成本。这些系统天生速度较慢,需要庞大的基础设施,

3 MIN READ

2025年 12月 16日

塑造 2025 年的 AI 工厂、物理 AI 以及模型、智能体和基础设施的进步

对于使用 NVIDIA 技术的开发者和研究人员而言,2025 年是又一个具有里程碑意义的年份。在数据中心功耗与计算设计、AI 基础设施、

3 MIN READ

2025年 12月 15日

如何使用强化学习训练科学智能体

科学过程可能重复且繁琐,研究人员往往需要花费数小时深入研读论文、管理实验流程或整理庞大的多模态数据集。科学 AI 智能体能够承担大量繁重任务,

3 MIN READ

2025年 12月 15日

NVIDIA CUDA-X 加速 DuckDB 全新 Sirius GPU 引擎,刷新 ClickBench 性能纪录

NVIDIA 正在与威斯康星大学麦迪逊分校合作,通过开源 Sirius 引擎将 GPU 加速分析引入 DuckDB。 DuckDB 因其简洁、

3 MIN READ

2025年 12月 15日

减小 CUDA 二进制大小以在 PyPI 上分发 cuML

从 25.10 版本开始,现在可以直接从 PyPI 下载用于 pip 安装的 cuML wheels。

3 MIN READ

2025年 12月 5日

NVIDIA Kaggle 大师夺冠人工智能竞赛

NVIDIA 的研究人员在周五的 Kaggle 竞赛中拔得头筹,这一赛事被业界许多人视为对人类在人工智能(AGI)领域进展的一次实时检验。

1 MIN READ

2025年 12月 4日

专注于你的算法——让 NVIDIA CUDA Tile 来处理硬件细节

NVIDIA CUDA 13.1 推出 NVIDIA CUDA Tile,这是自 2006 年 NVIDIA CUDA 平台发明以来,

2 MIN READ