新兴的 AI 模型在规模和复杂性上持续增长,对训练和推理的计算性能需求日益提升,已远超摩尔定律所能满足的范畴。这正是 NVIDIA 采用极致代码设计的原因。通过跨多个芯片与海量软件协同优化,AI 工厂的性能和效率实现了显著的代际跃升。

低精度 AI 格式是提升计算性能和能效的关键。要将超低精度数字的优势应用于 AI 训练和推理,同时维持较高的准确性,需在技术栈的每一层进行深入的工程设计。这包括格式的定义、在芯片中的实现、在众多库中的支持,以及与生态系统紧密协作,以部署新型训练方法和推理优化技术。 NVFP4,开发并实施于 NVIDIA GPU,自 NVIDIA Blackwell 架构起,提供 4 位浮点精度的性能与能效优势,同时保持与更高精度格式相当的准确性。

对于希望进一步提升 AI 训练和推理性能的人来说,以下是关于 NVFP4 的三件事。

1. NVFP4 为 Blackwell 架构上的训练和推理带来了显著的性能提升

NVIDIA Blackwell Ultra GPU 可提供高达 15 petaFLOPS 的峰值密集 NVFP4 吞吐量,达到同一 GPU 上 FP8 吞吐量的 3 倍。性能提升不仅体现在峰值指标上,也反映在训练和推理工作负载的实际表现中。

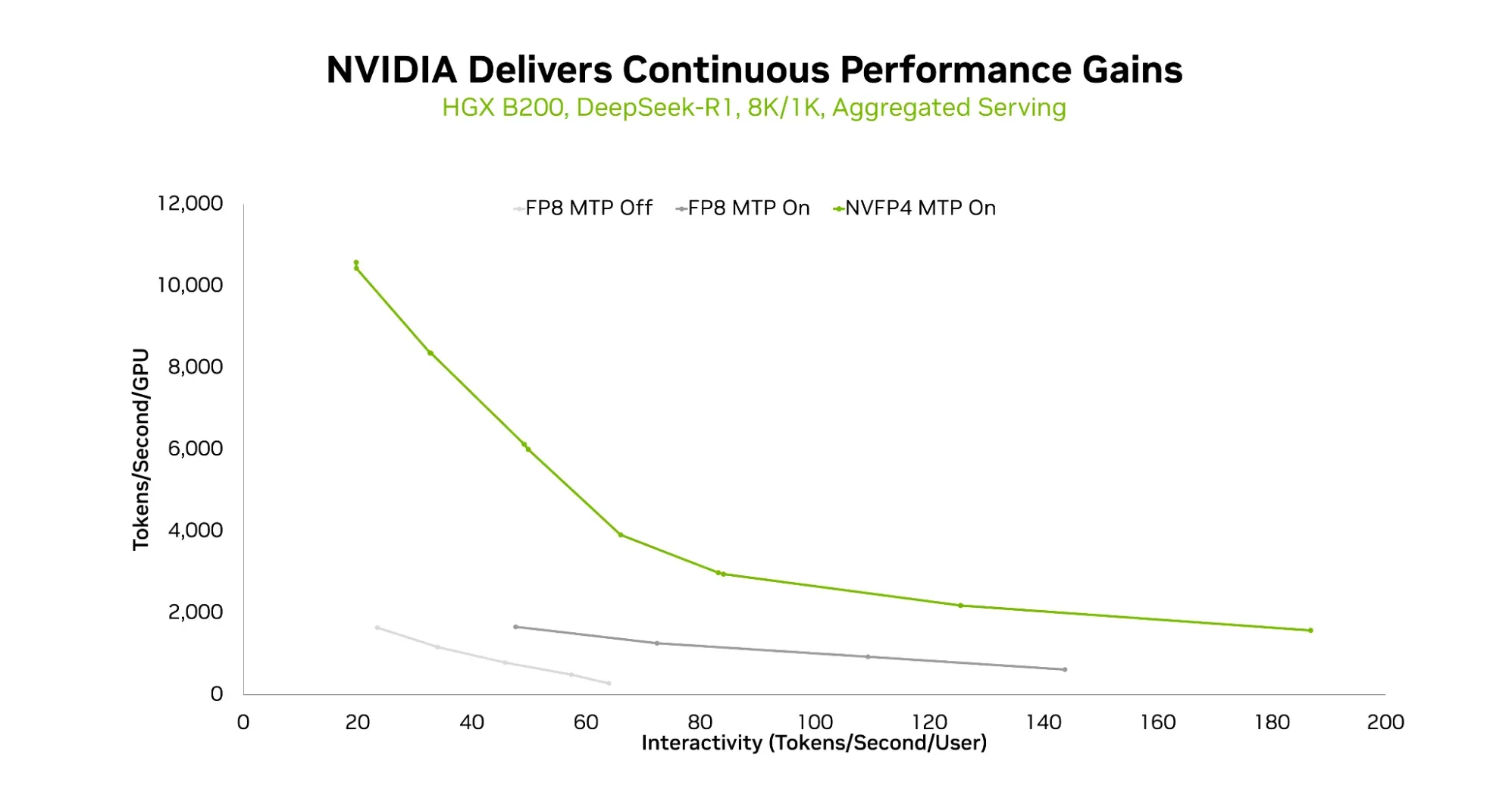

在推理方面,如近期一篇技术博客文章所示,从 FP8 过渡到 NVFP4,可显著提升 DeepSeek-R1(一种广受关注的 671B 参数混合专家(MoE)模型)在特定交互水平下的 token 吞吐量。吞吐量随给定 token 速率的提高而增长,且在更高 token 速率下表现更优,从而带来更佳的用户体验。

NVIDIA 近期还发布了 NVFP4 训练方法,将 NVFP4 的显著性能优势引入模型训练,使模型制造商能够以更低的成本更高效地训练 AI。

在最新一轮的 MLPerf Training 基准测试套件中,多个 NVIDIA GB300 NVL72 系统(共 512 个 Blackwell Ultra GPU)采用 NVFP4 精度协同运行,仅用 64.6 分钟便完成了 Llama 3.1 405B 的预训练基准测试。相较上一轮测试中使用 FP8 精度、由 512 个 Blackwell GPU 构成的多个 NVIDIA GB200 NVL72 系统,此次性能提升达 1.9 倍。

展望未来,NVIDIA Rubin 平台在 NVFP4 训练和推理能力方面将实现显著飞跃,可提供 35 petaFLOPS 的 NVFP4 训练计算性能和 50 petaFLOPS 的 NVFP4 Transformer 引擎推理计算性能。相较于 Blackwell,其性能分别提升了 3.5 倍和 5 倍。

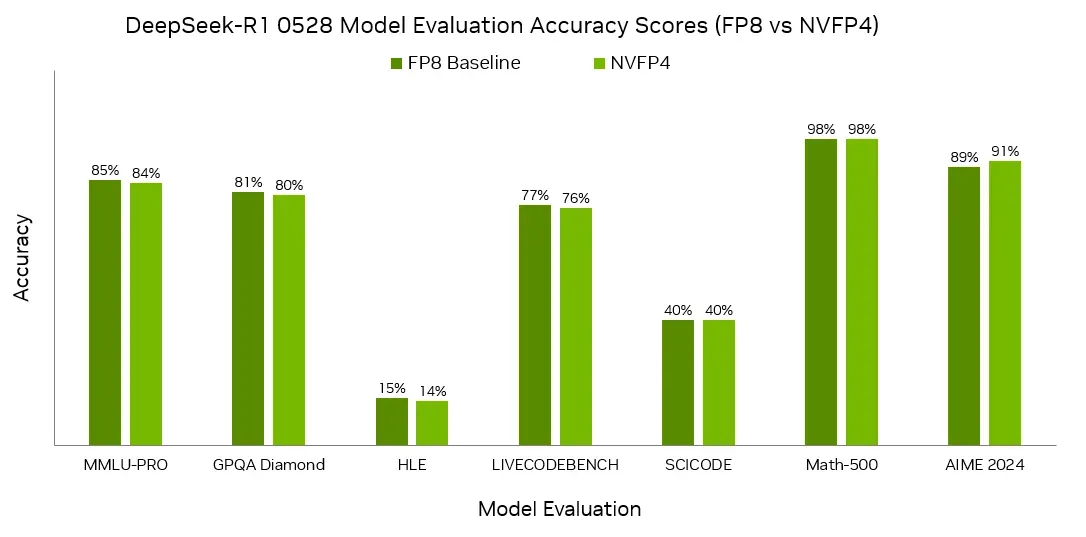

2. NVFP4 可提供卓越的准确性,并在行业基准测试中得到验证

要使封闭组中的 MLPerf 训练和推理提交有效,必须满足基准测试中规定的准确性要求。对于推理,响应需达到特定的准确性数值;对于训练,模型必须按照既定的质量目标进行训练(即模型训练过程必须收敛)。

在新版 MLPerf Training 中,NVIDIA 借助 Blackwell 架构上的 NVFP4 和 Blackwell Ultra GPU,成功提交了所有大语言模型(LLM)测试项目的封闭组结果。此外,NVIDIA 还在 MLPerf 推理测试中,针对多种模型和场景提交了使用 NVFP4 量化技术的版本,涵盖 DeepSeek-R1、Llama 3.1 8B 和 405B,以及 Llama 2 70B。这些模型在采用 NVFP4 量化格式的同时,依然满足了严格的基准测试要求。

3. NVFP4 获得广泛且持续扩展的生态系统支持

借助 NVIDIA Model Optimizer、LLM Compressor 和 torch.ao 等库,开发者能够将高精度训练的模型量化为 NVFP4,并实现 NVFP4 KV 缓存,在保持准确性的同时支持长上下文和大批量推理。主流推理框架(包括 NVIDIA TensorRT-LLM、vLLM 和 SGLang)目前已支持运行 NVFP4 格式的模型,并提供基于 NVFP4 的模型变体。例如,在 HuggingFace 上,开发者可以找到可直接部署的 NVFP4 版本 模型,如 Llama 3.3 70B、FLUX.2、DeepSeek-R1-0528、Kimi-K2-Thinking、Qwen3-235B-A22B,以及 NVIDIA Nemotron Nano。

该生态系统还采用 NVFP4 技术,以提升各类模型的生产推理吞吐量。采用该技术的公司包括 Black Forest Labs、Radical Numerics、Cognition 和 Red Hat。

Black Forest Labs 与 NVIDIA 合作,在 Blackwell 平台上针对 FLUX.2 扩展 NVFP4 推理。Black Forest Labs 联合创始人兼首席执行官 Robin Rombach 表示:“通过 CUDA Graphs、torch.compile、NVFP4 precision 和 TeaCache 等分层优化,我们在单个 B200 上实现了最高达 6.3 倍的加速,显著降低了延迟,推动了更高效的生产部署。”

Radical Numerics 利用 NVFP4 加速科学世界模型的扩展。Radical Numerics 联合创始人兼首席 AI 科学家 Michael Poli 表示:“与语言不同,科学数据推动我们超越经典的单模态自回归方法,需要采用超长上下文技术和稳健的多模态融合方案。” 他补充说,该公司对其新架构在低精度配方下的预训练与后训练前景“高度乐观” 。

Cognition 研究团队成员 Steven Cao 表示,通过在大规模强化学习中采用 NVFP4,Cognition 正在实现“显著的延迟降低和吞吐量提升”。

Red Hat 正在通过 NVFP4 量化 扩展其 LLM 工作负载,使开发者在 边缘和 MoE 模型 方面的基准准确性接近理想水平,同时保持在严格的内存预算范围内。NVFP4 能显著减少激活值和权重的占用空间,且不会造成显著的质量损失,从而使 Red Hat 工程师能够利用现有基础设施,在更大的上下文窗口和更高并发条件下训练与服务先进的 LLM。

NVIDIA Transformer 引擎库包含了 NVFP4 训练方案的实现,以及 Megatron-Bridge 等训练框架的集成,便于开发者快速上手。NVIDIA 还将持续创新,并与生态系统紧密协作,将 NVFP4 训练在性能和效率上的优势推广至整个生态,助力更智能、更复杂模型的加速训练与高效迭代。

了解详情

使用 NVFP4 可在 NVIDIA Blackwell 和 NVIDIA Rubin 平台上实现显著的性能提升。通过极致的代码设计,可在模型训练与推理中以优异的准确性达成这一提升。众多热门开放大语言模型的 NVFP4 版本已广泛可用,使服务能够以更高的吞吐量和更低的每百万 tokens 成本运行这些模型。

详细了解 Rubin 平台实现的重大架构突破(包括增强的 NVFP4)如何将 AI 训练和推理的性能提升至全新高度。