NVIDIA NeMo 检索器

NVIDIA NeMo™ Retriever 是一组行业领先的 Nemotron RAG 模型,能够实现 50% 更高的准确率、15 倍更快的多模态 PDF 提取速度,以及 35 倍更高的存储效率,帮助企业构建检索增强生成(RAG)流程,从而提供实时业务洞察。NeMo Retriever 属于 NVIDIA NeMo 软件套件的一部分,该套件用于管理 AI 智能体的生命周期,确保数据隐私,并可无缝连接到任意位置的专有数据,助力构建安全的企业级检索系统。NeMo Retriever 是 NVIDIA AI-Q(用于构建智能 AI 智能体的蓝图)和 NVIDIA RAG 蓝图的核心组成部分,使企业能够访问其 AI 数据平台中的知识资源。它为可扩展、可投入生产的检索流程提供了可靠的基础,支持先进的 AI 应用。

NeMo Retriever 微服务为企业级 RAG 应用树立了全新行业标准,在三大视觉文档检索榜单(ViDoRe V1、ViDoRe V2、MTEB 和 MMTEB VisualDocumentRetrieval)中均位列领先位置。

文档

借助可扩展的数据提取以及高精度嵌入和重排序,构建出色的信息检索工作流和 AI 查询引擎。

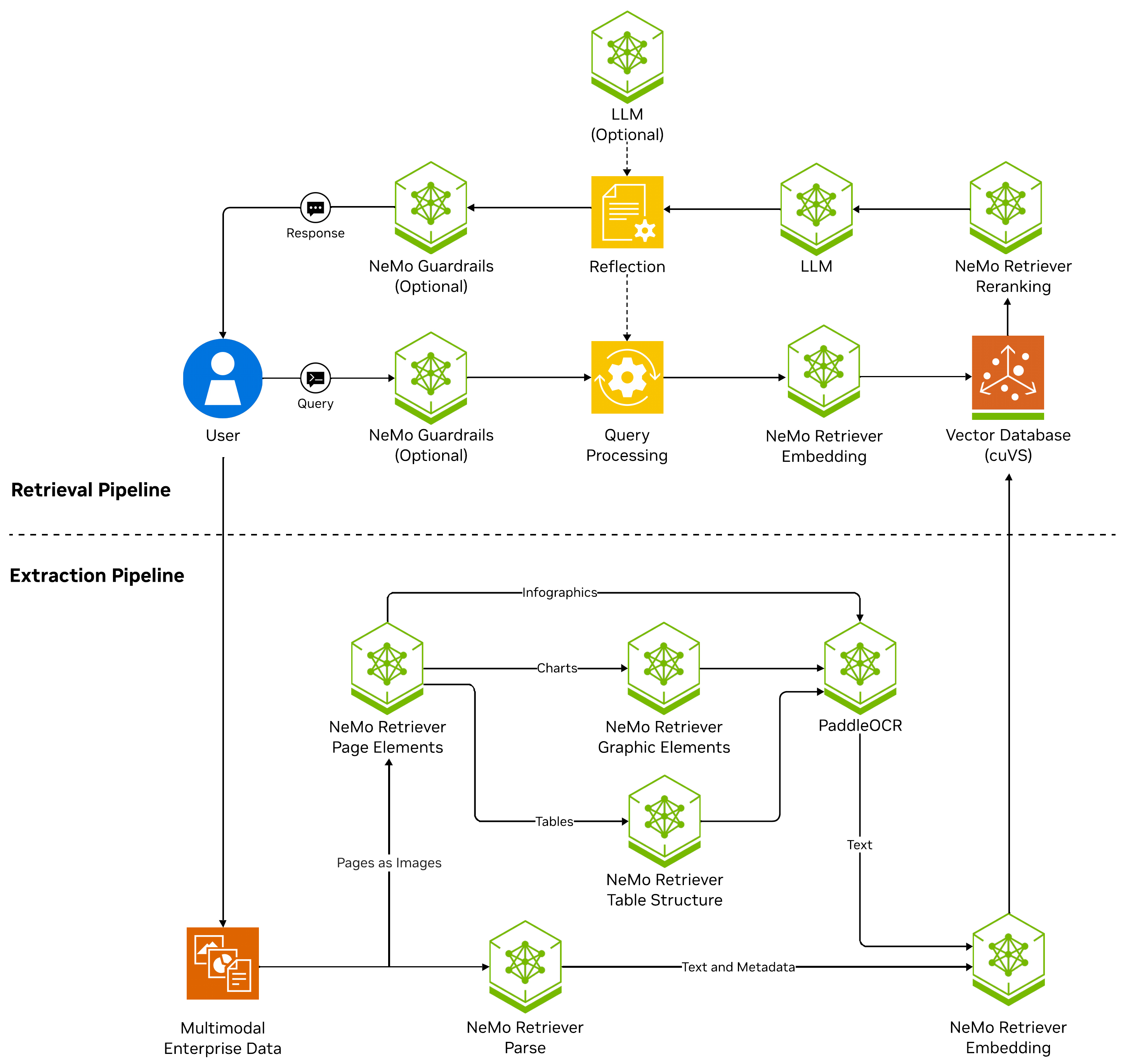

NVIDIA NeMo 检索器的工作原理

NeMo Retriever 提供用于构建数据提取和信息检索工作流的组件。流程提取结构化和非结构化数据 (例如。文本、图表、表格) ,将其转换为文本,然后过滤掉重复内容。NeMo Retriever 嵌入 NIM 将数据块转换为嵌入,并将其存储在由 NVIDIA cuVS 加速的向量数据库中,以提高索引和搜索的性能和速度。

NeMo Retriever 解析这是一种基于 VLM 的 OCR 微服务,用于文本和表格提取,可保留语义结构,按读取顺序将文档图像转录为文本,对内容类型进行分类,并输出结构化标记以保留空间布局和格式。

提交查询时,系统使用向量相似性搜索检索相关信息,然后使用 NeMo Retriever 重排序 NIM 对结果进行重新排序,以确保准确性。借助最相关的信息,LLM NIM 会生成信息丰富、准确且与上下文相关的回复。您可以使用 NVIDIA API Catalog 中的各种 LLM NIM 微服务来启用其他功能,例如合成数据生成。

入门资源

详细了解如何使用 NeMo Retriever 构建高效的信息检索工作流。

出色的信息检索性能

NeMo Retriever 微服务可加速多模态文档提取和实时检索,同时降低 RAG 成本并提高准确性。它们支持可靠的多语种跨语言检索,并优化数据平台的存储、性能和适应性,从而实现高效的向量数据库扩展。

错误答案减少 50%

NeMo Retriever 多模态提取召回率 = 5 准确率

与关闭 NeMo Retriever 的比较:开源替代方案:HW - 1xH100

嵌入吞吐量提高 3 倍

NeMo Retriever Llama 3.2 多语种文本嵌入

多模态数据提取吞吐量提高 15 倍

NeMo Retriever Extraction NIM 微服务

数据存储效率提高 35 倍

多语种、长上下文、文本嵌入 NIM 微服务

.svg)

开始使用 NVIDIA NeMo Retriever 的方法

使用合适的工具和技术构建和部署生成式 AI 应用,这些应用需要安全准确的信息检索,以便为各行各业的组织生成实时业务见解。

入门套件

开始为多模态数据提取、嵌入、重排序、检索增强生成和代理式工作流构建信息检索工作流和生成式 AI 应用 NVIDIA Blueprints、教程、Notebook、博客、论坛、参考代码、综合文档等。

客服 AI 助手

利用 RAG、NeMo Retriever、NIM 和最新的 AI 智能体构建方法,构建更个性化、更安全的增强型 AI 助手。

NVIDIA NeMo 检索器学习资源库

更多资源

AI 伦理

NVIDIA 的平台和应用框架使开发者能够构建各种 AI 应用。在选择或创建要部署的模型时,请考虑潜在的算法偏差。与模型的开发者合作,确保其满足相关行业和用例的要求;提供必要的说明和文档以了解错误率、置信区间和结果;并确保在预期的条件和方式下使用模型。