Blackwell

2026年 3月 5日

NVIDIA Blackwell 刷新金融领域大模型推理 STAC-AI 历史纪录

大语言模型(LLM)通过精密分析大量非结构化数据,生成切实可行的交易见解,正在重塑金融交易格局。这些先进的 AI 系统能够处理金融新闻、

3 MIN READ

2026年 2月 25日

借助 NVIDIA Blackwell Ultra 提升 Softmax 的效率

LLM 上下文长度呈爆炸式增长,架构正朝着更复杂的注意力机制发展,例如多头潜在注意力(MLA)和分组查询注意力(GQA)。因此,

2 MIN READ

2026年 2月 23日

采用 NVFP4 低精度训练提升吞吐量,兼顾精度无损

随着 AI 模型和数据集规模的不断扩大,仅依赖更高精度的 BF16 训练已难以满足需求。训练吞吐量预期、内存限制以及成本上升等关键挑战,

3 MIN READ

2026年 2月 18日

NVIDIA 极致软硬件协同设计如何助力 Sarvam AI 主权模型实现惊人推理性能跃升

随着全球人工智能采用的加速,开发者面临日益严峻的挑战:如何提供符合现实世界延迟和成本要求的大语言模型(LLM)性能。

4 MIN READ

2026年 2月 9日

借助 NVIDIA TensorRT LLM AutoDeploy 实现推理优化自动化

NVIDIA TensorRT LLM 使开发者能够为大语言模型 (LLM) 构建高性能推理引擎,但传统上部署新架构往往需要大量手动工作。

3 MIN READ

2026年 2月 6日

NVFP4 加速 AI 训练与推理的三大方式

新兴的 AI 模型在规模和复杂性上持续增长,对训练和推理的计算性能需求日益提升,已远超摩尔定律所能满足的范畴。

2 MIN READ

2026年 2月 2日

使用混合专家并行优化混合专家训练的通信

在 LLM 训练中,超大规模多专家模型 (MoE) 的专家并行 (EP) 通信面临巨大挑战。EP 通信本质上属于多对多模式,

4 MIN READ

2026年 1月 22日

在 NVIDIA Blackwell 数据中心 GPU 上实现 FLUX.2 的 NVFP4 推理扩展

2025 年,NVIDIA 与 Black Forest Labs (BFL) 合作优化 FLUX.1 文本转图像模型系列,

3 MIN READ

2026年 1月 8日

借助 NVIDIA Blackwell 实现多专家模型推理的巨大性能飞跃

随着 AI 模型持续变得更加智能,人们能够依赖它们完成日益增多的任务。这导致用户(从消费者到企业)与 AI 的交互愈发频繁,

2 MIN READ

2026年 1月 5日

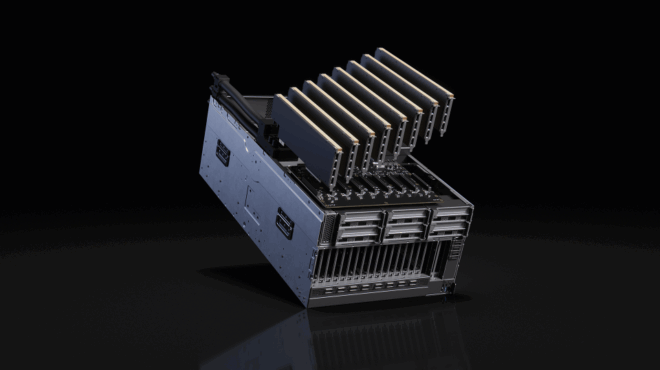

深度解析 NVIDIA Rubin 平台:六款新芯片打造AI超级计算机

AI 已进入工业阶段。 最初是用于执行离散 AI 模型训练和面向人类推理的系统,现已演变为全天候运行的 AI 工厂,持续将功率、

12 MIN READ

2025年 12月 17日

使用 NVIDIA cuDSS 解决大规模线性稀疏问题

随着芯片设计、制造和多物理场仿真复杂性的持续提升,在电子设计自动化(EDA)、

5 MIN READ

2025年 12月 16日

使用 NVIDIA CUDA MPS 无需修改代码即可提升 GPU 显存性能

NVIDIA CUDA 开发者可以利用多种工具和库来简化开发与部署,使用户能够专注于应用程序的“内容”和“方式”。 多进程服务 (MPS)…

5 MIN READ

2025年 12月 16日

使用 Skip Softmax 加速 NVIDIA TensorRT-LLM 中的长上下文推理

对于大规模部署 LLM 的机器学习工程师来说,这个等式既熟悉又无情:随着上下文长度的增加,注意力计算成本呈爆炸式增长。

4 MIN READ

2025年 12月 15日

利用 NVIDIA MGX 为未来数据中心提供灵活高效性能

重塑计算格局的 AI 热潮将在 2026 年进一步加速扩展。随着模型能力与计算能力的突破持续推动发展,

2 MIN READ

2025年 12月 12日

如何在现代 NVIDIA GPU 架构上扩展快速里叶变换以实现百亿亿次级计算

快速里叶变换 (FFT) 广泛应用于科学计算,涵盖分子动力学、信号处理、计算流体动力学 (CFD)、无线多媒体以及机器学习等领域。

4 MIN READ

2025年 12月 8日

使用 NVFP4 KV 缓存优化大批次与长上下文推理

量化是大规模推理中的关键手段之一。通过降低权重、激活值和KV缓存的精度,可以有效减少内存占用和计算开销,从而显著提升推理吞吐量、降低延迟,

3 MIN READ