云服务

2026年 1月 22日

在 NVIDIA Blackwell 数据中心 GPU 上实现 FLUX.2 的 NVFP4 推理扩展

2025 年,NVIDIA 与 Black Forest Labs (BFL) 合作优化 FLUX.1 文本转图像模型系列,

3 MIN READ

2026年 1月 8日

借助 NVIDIA Blackwell 实现多专家模型推理的巨大性能飞跃

随着 AI 模型持续变得更加智能,人们能够依赖它们完成日益增多的任务。这导致用户(从消费者到企业)与 AI 的交互愈发频繁,

2 MIN READ

2026年 1月 5日

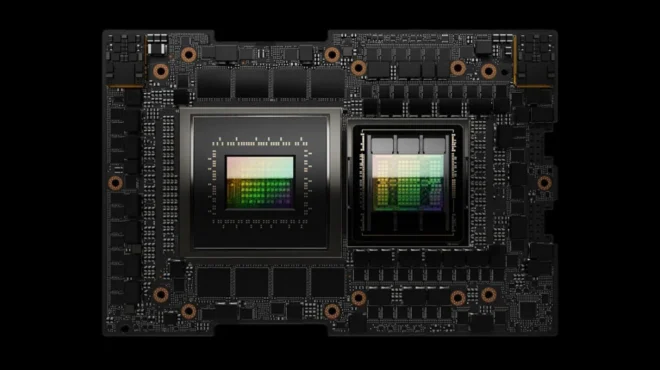

深度解析 NVIDIA Rubin 平台:六款新芯片打造AI超级计算机

AI 已进入工业阶段。 最初是用于执行离散 AI 模型训练和面向人类推理的系统,现已演变为全天候运行的 AI 工厂,持续将功率、

12 MIN READ

2025年 12月 16日

使用 NVIDIA CUDA MPS 无需修改代码即可提升 GPU 显存性能

NVIDIA CUDA 开发者可以利用多种工具和库来简化开发与部署,使用户能够专注于应用程序的“内容”和“方式”。 多进程服务 (MPS)…

5 MIN READ

2025年 12月 12日

在 Kubernetes 上实现企业级 RAG 组件的横向自动扩展

当今出色的 AI 智能体 依靠 检索增强生成 (RAG) 来实现更准确的结果。一个 RAG 系统通过利用知识库,为 大语言模型 (LLM)…

11 MIN READ

2025年 12月 10日

借助 NCCL Inspector 增强 AI 工作负载的通信可观测性

使用 NVIDIA 集合通信库 (NCCL) 运行包含集合运算(例如 AllReduce、

3 MIN READ

2025年 12月 8日

使用 NVFP4 KV 缓存优化大批次与长上下文推理

量化是大规模推理中的关键手段之一。通过降低权重、激活值和KV缓存的精度,可以有效减少内存占用和计算开销,从而显著提升推理吞吐量、降低延迟,

3 MIN READ

2025年 12月 8日

使用 NVSentinel 自动监控 Kubernetes AI 集群健康状态

Kubernetes 支持生产环境中绝大多数 AI 工作负载。然而,维护 GPU 节点、保障应用稳定运行、持续推进训练任务,

2 MIN READ

2025年 11月 24日

模型量化:核心概念、实现方法与关键作用

随着 AI 模型日益复杂,往往超出可用硬件的承载能力,量化技术已成为应对这一挑战的关键手段,使资源密集型模型得以在受限的硬件上运行。

5 MIN READ

2025年 11月 10日

在 Kubernetes 上启用 NVIDIA GB200 NVL72 及以上型号的多节点 NVLink

NVIDIA GB200 NVL72 将 AI 基础设施提升至全新高度,在大语言模型训练以及可扩展、低延迟推理工作负载的运行方面实现显著突破。

4 MIN READ

2025年 11月 10日

在 NVIDIA NCCL 2.28 中使用新的 Device API 和基于拷贝引擎的集合通信实现通信和计算的融合

NVIDIA 集合通信库(NCCL)的最新版本引入了突破性的通信与计算融合技术,可显著提升多 GPU 和多节点系统中的通信吞吐量,降低延迟,

3 MIN READ

2025年 10月 30日

在 Microsoft Azure 上利用 NVIDIA Run:ai 简化 AI 基础设施

现代人工智能工作负载,无论是大规模训练还是实时推理,都需要动态访问高性能 GPU 资源。然而,

3 MIN READ

2025年 10月 16日

NVIDIA Blackwell 在 SemiAnalysis InferenceMAX v1 基准测试中取得领先表现

SemiAnalysis 近期推出了 InferenceMAX v1,这是一项全新的开源计划,旨在提供一套全面评估推理硬件性能的方法。

3 MIN READ

2025年 10月 14日

硬件一致性平台上的内存管理深入剖析

如果您是应用程序开发者或集群管理员,可能已经意识到非统一内存访问(NUMA)会对系统性能产生显著影响。

2 MIN READ

2025年 10月 6日

GPU 原生 Velox 和 NVIDIA cuDF 加速大规模数据分析

随着工作负载规模的扩大以及对高效数据处理需求的提升,相比基于 CPU 的系统,采用 GPU 加速的数据库和查询引擎在性价比方面展现出显著优势。

2 MIN READ