生成式 AI 具有改变各个行业的巨大潜力。人类工作者已经开始使用 大型语言模型(LLM) 来解释、推理和解决复杂的认知任务。检索增强生成(RAG) 将 LLM 与数据连接起来,通过允许 LLM 访问准确和最新的信息,扩展了 LLM 的功能。

许多企业已经开始探索 RAG 如何帮助他们实现业务流程自动化和挖掘数据以获取见解。尽管大多数企业已经启动了多个与生成式 AI 用例一致的试点,据估计,其中 90%的模型在不久的将来不会超出评估阶段。将引人入胜的 RAG 演示转化为可提供真正商业价值的生产服务仍然具有挑战性。

在这篇博客中,我们将介绍 NVIDIA AI 如何通过四个步骤帮助您将 RAG 应用从试点阶段迁移到生产阶段。

构建企业就绪型 RAG 工作流

开发和部署生产就绪型企业 RAG 工作流会遇到许多障碍。

IT 管理员面临着与 LLM 安全性、可用性、可移植性和数据治理相关的挑战。企业开发者可能难以满足 LLM 的准确性和 LLM 编程框架的整体成熟度。开源创新的绝对速度对每个人来说都是巨大的,新的 LLM 模型和 RAG 技术每天都在出现。

用于简化生产 RAG 开发和部署的基础模组

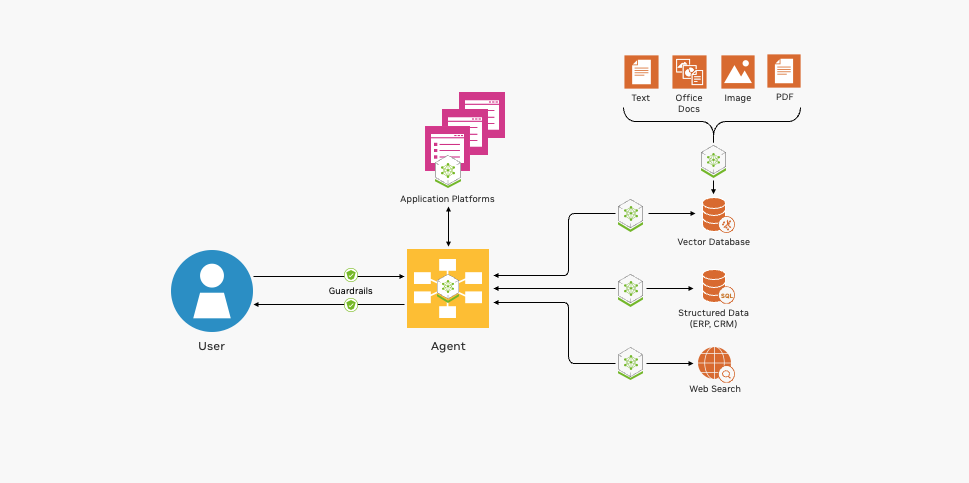

NVIDIA 通过为云原生端到端 RAG 应用提供参考架构来帮助管理这种复杂性。该参考架构是模块化的,将热门开源软件与 NVIDIA 加速相结合。利用全套模块化构建模块具有以下优势。

- 首先,企业可以有选择地将新组件集成到现有基础架构中。

- 其次,他们可以为流程的每个阶段选择商用组件和开源组件。企业可以为自己的用例选择合适的组件,同时避免供应商锁定。

- 最后,模块化架构简化了管道每个阶段的评估、观察和故障排除。

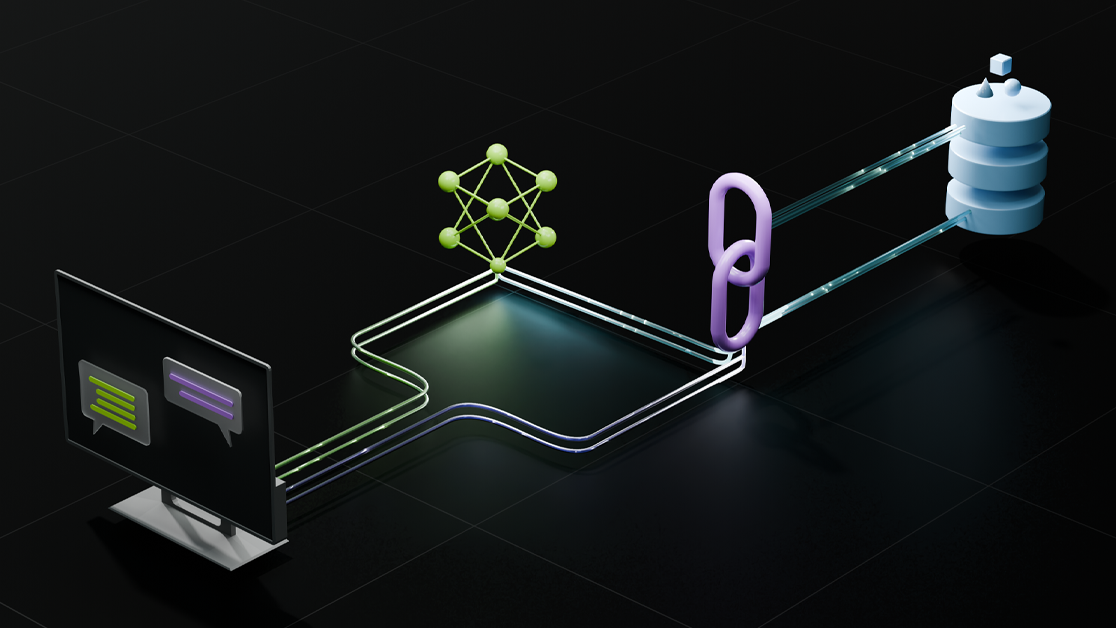

图 1 显示了部署 RAG 管道的基本构建块。

NVIDIA 提供开源集成、GPU 加速容器等,帮助您开发 RAG 应用。

与热门框架和工具的开源集成

NVIDIA 提供流程示例,帮助启动 RAG 应用程序开发。 NVIDIA RAG 流程示例向开发者展示如何将主流开源 LLM 编程框架 (包括 LangChain、LamaIndex 和干草堆栈) 与 NVIDIA 加速软件相结合。通过将这些示例作为起点,企业开发者可以享受两全其美的体验,将开源创新与加速性能和规模相结合。

这些示例还展示了与热门开源工具的集成,用于评估、工作流可观察性和数据提取,从而使第二天的工作流操作更加简单且更具成本效益。

GPU 加速容器可实现快速、准确的响应

LLM 驱动的企业 RAG 应用必须快速响应且准确无误。基于 CPU 的系统无法提供企业级可接受的性能。NVIDIA API 目录 提供了支持 RAG 管道各个阶段的容器,这些管道受益于 GPU 加速。

- NVIDIA NIM 提供了优化 LLM 推理的性能和可扩展性。

- NVIDIA NeMo Retriever 可以简化并加速 RAG 流程的核心功能,包括文档嵌入、检索和查询。

- NVIDIA RAPIDS 加速了对存储在数据库中的企业数据向量表示的搜索和索引。

支持多模态输入、输出和数据处理

RAG 应用程序正迅速从基于文本的聊天机器人发展为复杂的事件驱动型工作流,涉及图像、音频和视频等各种模式。 NVIDIA AI 软件增强了 RAG 流程的可用性和功能,以解决这些新兴用例。

- NVIDIA Riva 提供 GPU 加速的文本转语音、语音转文本和翻译接口,以便使用口语与 RAG 流程进行交互。

- NVIDIA RAPIDS 可以通过 GPU 加速由 LLM 代理触发的操作。例如,LLM 代理可以调用 RAPIDS cuDF 对结构化数据执行统计数学计算。

- NVIDIA Morpheus 可以用来预处理大量企业数据,并能实时提取这些数据。

- NVIDIA Metropolis 和 NVIDIA Holoscan 为 RAG 管道添加了视频和传感器处理功能。

企业开发者可以利用 NVIDIA AI Enterprise 来为生成式 AI 应用提供更快速、更高效的运行时。

将 RAG 应用从试点阶段推向生产的四个步骤

构建生产级 RAG 应用需要许多利益相关者之间的协作。

- 数据科学家评估 LLM 的性能和准确性。

- 企业 AI 开发者编写、测试和改进 RAG 应用。

- 数据工程师连接和转换企业数据以进行索引和检索。

- MLOps、DevOps 和现场可靠性工程师 (SRE) 部署和维护生产系统。

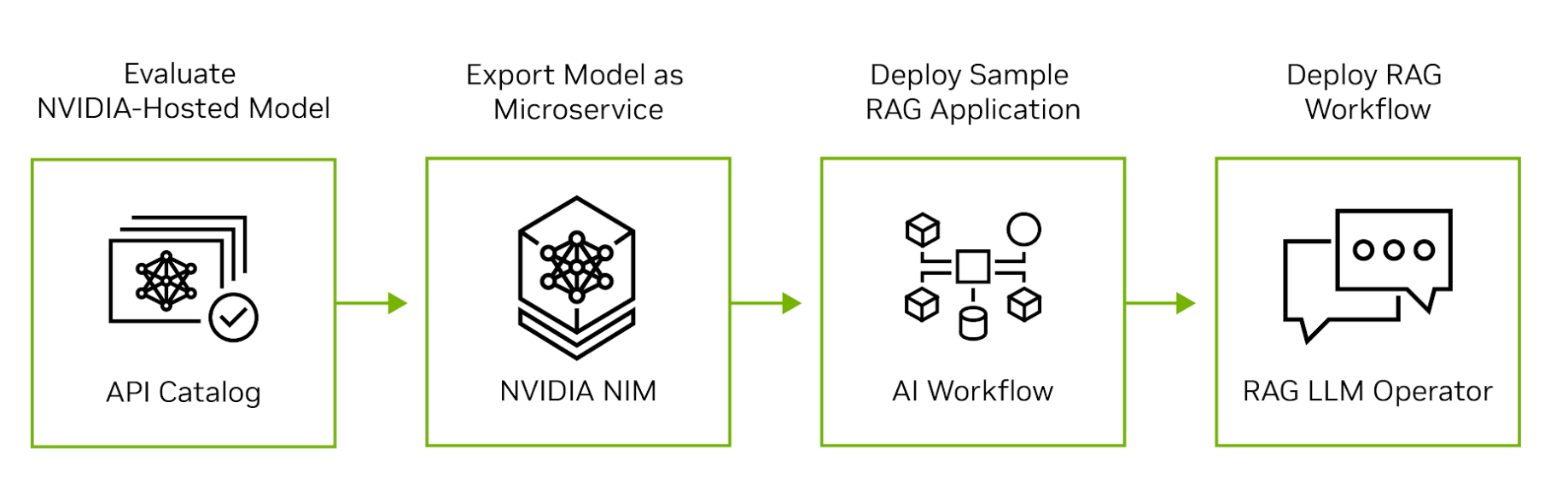

NVIDIA AI 从云扩展到芯片,为 RAG 应用开发、部署和运营的每个阶段提供支持。图 2 显示了将 RAG 应用从评估迁移到生产的四个步骤。

第 1 步:评估 NVIDIA API 目录中的 LLM

首先,请访问 NVIDIA API 目录,体验在 NVIDIA GPU 上运行的领先开源和商用模型。开发者可以通过用户界面与模型进行交互,然后查看交互生成的后端 API 调用。API 调用可以导出为 Python、Go 或 TypeScript 代码片段,也可以导出为 shell 脚本。

第 2 步:将模型导出为微服务

接下来,将模型导出为 NVIDIA NIM.NIM 是一种易于使用的自托管微服务,旨在加速生成式 AI 的部署。该微服务可以在任何主要云上作为虚拟机中的容器运行,也可以通过 Helm 将其安装到 Kubernetes 集群中。如果您对数据隐私或安全有任何疑问,可以在自己的数据中心或虚拟私有云中评估模型。

第 3 步:开发 RAG 示例应用

在评估自托管模型后,探索 NVIDIA 生成式 AI 示例,以编写 RAG 应用示例。这些示例展示了 NVIDIA 微服务如何与流行的开源 LLM 编程框架集成,从而实现端到端的 RAG 流程。数据科学家可以使用这些示例来调整应用性能并评估其准确性。 NVIDIA AI Enterprise 客户还可以访问 NVIDIA AI 工作流程,以了解如何将生成式 AI 示例应用于行业特定的用例。

第 4 步:将 RAG 工作流部署到生产环境

应用程序开发完成后,MLOps 管理员可以使用 NVIDIA RAG LLM Operator 将它部署到测试或生产命名空间。通过抢先体验RAG LLM Operator,可以快速轻松地将 RAG 应用程序部署到 Kubernetes 集群中,而不需要重写任何应用程序代码。

RAG LLM 运算符在 NVIDIA GPU Operator 中运行,这是一款流行的基础设施软件,可以在 Kubernetes 上自动部署和管理 NVIDIA GPU。它简化了生命周期管理的复杂性,并实现了 RAG 流程的无缝部署、扩展和管理。

提高生产力的 RAG 流程

生产 RAG 系统可以通过减轻工作量、使相关数据更易于查找以及实现事件自动化来提高工人的生产力。

NVIDIA 使用 RAG 流程来帮助构建安全的企业软件。 NVIDIA CVE 分析工具将 NVIDIA NIM、NeMo Retriever 和 Morpheus 网络安全 AI 框架相结合,以识别和筛选 NGC 容器中的常见漏洞和暴露 (CVE).这一关键的业务流程 (确保发布到 NGC 容器注册表的所有容器的完整性) 现在需要数小时而不是几天。

Deepset、桑迪亚国家实验室、Infosys、Quantiphi、Slalom 和 Wipro 等组织正在利用 NVIDIA 生成式 AI 获得宝贵见解,从而实现对企业数据的语义搜索。

Deepset 的全新“干草堆栈 2.0 (Haystack 2.0)”与 NVIDIA NIM 和 NeMo Retriever 的集成 帮助组织高效检查 GPU 加速的 LLM,以支持 RAG 应用程序的快速原型设计。

**桑迪亚国家实验室和 NVIDIA 正在合作评估新兴的生成式 AI 工具,以便在提高准确性和性能的同时,更大限度地获取数据见解。

Infosys 扩大了与 NVIDIA 的战略合作,作为Infosys 生成式 AI的一部分,Infosys Topaz 借助 NVIDIA NeMo 为各行各业创建企业就绪型 RAG 应用。这些应用颠覆了规范,并为生物制药临床试验报告自动化以及从超过 100000 份专有财务文档中寻找见解等用例提供价值。

Quantiphi 采用 NVIDIA 加速的生成式 AI 来开发基于 RAG 的解决方案,这些解决方案可以从庞大的药物研发文档库中提取见解,并通过优化针对人口统计和地理位置定制的零售供应链来帮助实现突破性成果。

Slalom 正在利用可靠的框架协助组织驾生成式 AI 和 RAG 的复杂性,包括设计、实施和治理,以降低风险并确保负责任地应用 AI。

借助 生成式 AI 工具,Wipro 正在帮助医疗健康组织改善向全美数百万患者提供的服务,从而提高医疗效果。

开始使用

越来越多的企业开始采用生成式 AI 来应对复杂的业务挑战并提高员工工作效率。许多企业还将在其产品中采用生成式 AI.企业可以依靠 NVIDIA AI Enterprise 提供的安全性、支持和稳定性,将其 RAG 应用程序从试点转向生产。通过标准化 NVIDIA AI,企业获得了忠实的合作伙伴,帮助他们跟上快速发展的 LLM 生态系统的步伐。

通过探索 NVIDIA 生成式 AI 示例,您可以开始构建聊天机器人,这些机器人能够利用最新信息,并以自然语言准确回答特定领域的问题。

如果您想了解构建 RAG 应用的新创新和最佳实践,请查看检索增强生成会话,该会将在NVIDIA GTC 2024的3月18日至21日举行。此外,您还可以参加 RAG 开发者日,了解如何使用人类语音界面构建由 RAG 驱动的应用。