要让人形机器人真正有用,它们需要具备认知能力和移动操作能力,涵盖感知、规划以及在动态环境中的全身控制。

构建通用机器人需要一个统一的仿真、控制与学习工作流——让机器人能够在安全的环境中获取复杂技能,然后再迁移到真实世界中。

在本文中,我们将介绍 NVIDIA Isaac GR00T N1.6 以及一套从仿真到现实的工作流,该工作流结合了在 NVIDIA Isaac Lab 中进行的全身强化学习(RL)、通过 COMPASS 利用合成数据训练的导航,以及使用 NVIDIA CUDA 加速的视觉映射与 SLAM 实现基于视觉的定位。

这些组件使机器人能够实现移动操作、稳健的导航以及环境感知行为,适用于多种机器人形态。

视觉–语言–动作模型与推理

GR00T N1.6 是一个多模态视觉-语言-动作(VLA)模型,能够将机器人自视角摄像头流、机器人状态以及自然语言指令整合为统一的策略表示。该模型使用 NVIDIA Cosmos Reason 等世界模型,将高级指令分解为基于场景理解的逐步动作计划,从而执行真实世界任务。这种架构允许 GR00T 执行移动和灵巧操作,通过端到端学习的表示完成控制。

GR00T N1.6 在上一版本基础上进行了多项增强,进一步提升能力和现实世界适用性:

- 增强推理与感知:使用 Cosmos-Reason-2B VLM 变体,支持原生分辨率,使机器人“看得更清楚”,并能更好地理解环境并转化为更可靠的场景理解和任务分解能力。

- 流畅、自适应的动作:提升至 2 倍的 Diffusion Transformer(32 层)以及状态相关动作预测,使动作更平滑、抖动更少,并能适应位置变化。

- 优化的跨形态性能:在数千小时多样化遥操作数据(人形机器人、移动机械臂、双手机械臂)上训练,使模型在多种机器人形态上泛化能力更强。

GR00T N1.6 配备了预训练权重,可支持零样本评估与验证基本操作原语,但如果要针对特定机器人形态或任务部署 GR00T N1.6,仍建议对模型进行微调以满足具体需求。

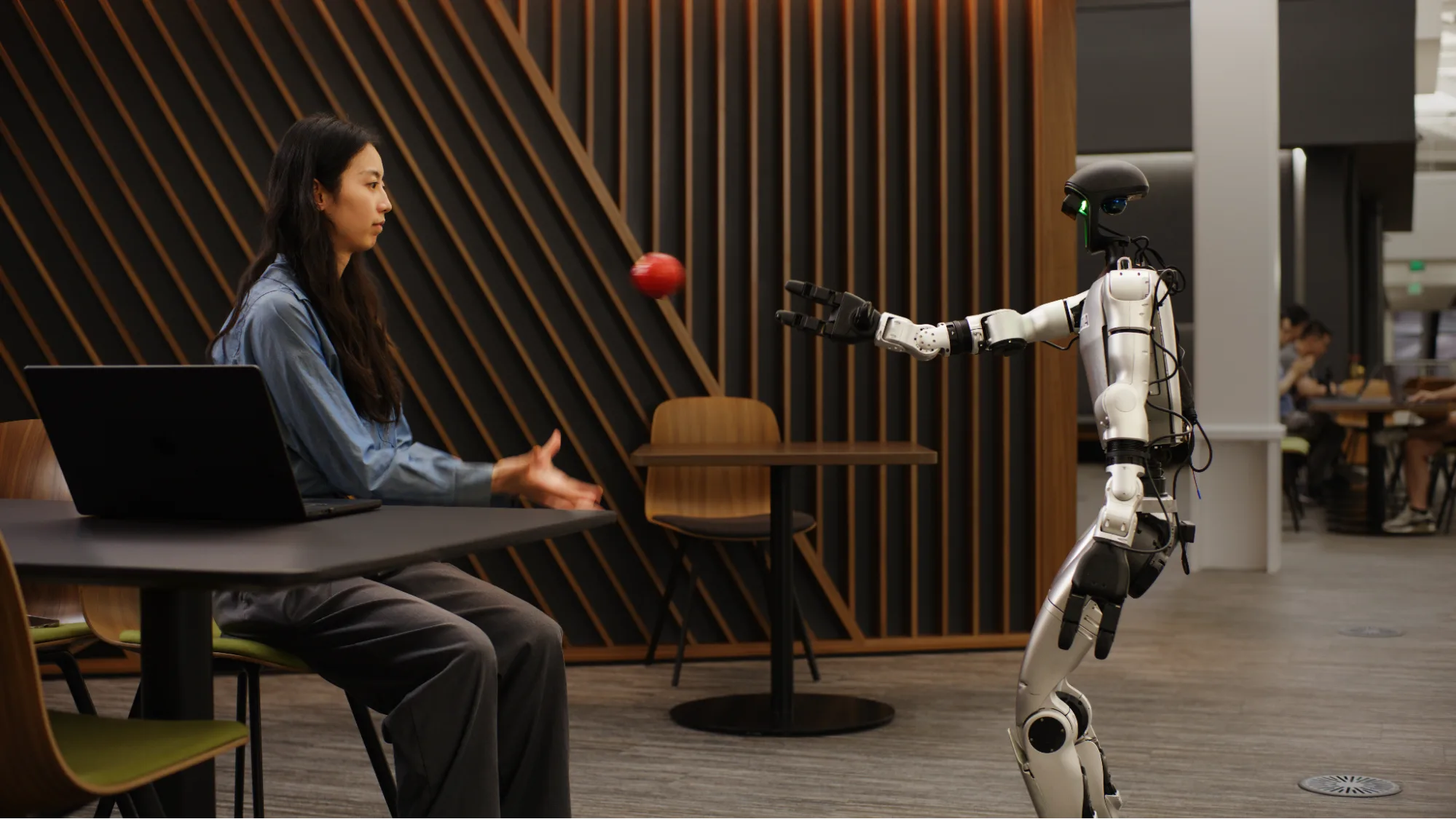

CoRL 2025 展示了 GR00T N1.6 在 G1 人形机器人上执行移动操作任务的效果。

视频 1. 用于机器人训练的神经仿真生成合成数据

全身 RL 训练与仿真到现实的迁移

RL 训练在仿真中为 GR00T N1.6 提供了可使用的底层运动智能,并通过高层 VLA 策略进行协调。在 Isaac Lab 中通过 RL 训练的全身控制器生成与人类似、动态稳定的运动原语,涵盖行走、操作以及接触密集型协调行为。

这些策略在 Isaac Lab 和 Isaac Sim 中进行大规模训练和压力测试,然后零样本迁移到真实机器人上,最大限度减少针对特定任务的微调,同时在各种环境和机器人形态中保持稳健性。仿真到现实的流程允许 GR00T 的高层 VLA 专注于任务顺序和场景感知决策,而无需操心底层运动的稳定性。

GR00T-WholeBodyControl 作为全身控制器,为 GR00T N1.6 提供底层的移动操作层。使用该控制器即可形成完整栈:高层指令跟随、中层行为组合、底层稳健控制,所有环节在仿真中验证后再部署到硬件。

基于合成数据训练的导航

为了在全身控制基础上实现目标导向的导航,GR00T N1.6 通过 COMPASS 在 Isaac Lab 生成的大规模合成数据集上微调,实现点到点导航。在此流程中,COMPASS 担任导航专家,生成覆盖不同场景和机器人形态的多样轨迹,用于将 GR00T 从 VLA 模型转化为强大的导航策略。

导航策略在仿真中训练,并通过简单速度命令控制全身控制器,而不是直接产生关节力矩。这样,底层全身 RL 策略负责保持平衡与接触处理,而导航头专注于避障、路径跟随和导航-操作衔接。实验表明,这种纯仿真训练流程实现了零样本仿真到显示的迁移,可在全新的物理环境中零样本部署,无需额外针对特定任务采集数据。

COMPASS 是一个开发跨形态移动策略的全新工作流,结合模仿学习、残差 RL 和策略蒸馏,已在 Isaac Lab 中验证了 RL 微调和零样本仿真到现实的有效性。

图 1. 采用 COMPASS 工作流的 GR1 机器人

基于此,GR00T N1.6 PointNav 示例发布了逐步指南和代码,帮助开发者微调和评估使用 COMPASS 生成数据的导航策略,从而复现并将导航栈扩展到不同机器人形态和场景。

视频 2. NVIDIA 机器人运动工作流与 AI 模型

基于视觉的定位

基于视觉的定位使 GR00T N1.6 能够在大型真实世界环境中使用全身控制器和导航策略。在全身 RL 赋予机器人稳健的移动操作技能、并通过 COMPASS 合成数据微调点到点导航后,系统仍需准确估计机器人的位置,使命令和路径点与真实坐标对应。

为此,视觉映射与定位栈利用搭载在边缘端的摄像头和预构建地图保持低漂移位姿估计,使机器人命令能精确对应机器人和物体坐标。

视觉映射与定位栈基于 NVIDIA Isaac 和 NVIDIA CUDA-X 库并采用以下立体深度模型构建:

- cuVSLAM:实时视觉-惯性 SLAM 与里程计库。里程计提供平滑速度估计,SLAM 后端生成低漂移位姿并支持闭环校正。

- cuVGL:视觉全局定位库,在预构建地图中计算初始位姿,用于启动 cuVSLAM。

- FoundationStereo:立体深度基础模型,在不同环境中实现强零样本泛化。

- nvblox:高效 3D 感知库,重建环境并生成 2D occupancy 图,用于路径规划。

我们收集环境立体图像并预构建地图,包括 cuVSLAM landmark 图、cuVGL bag-of-words 图以及 occupancy 图。occupancy 图中标注厨房桌等语义位置,用于任务规划。

运行时,cuVGL 从预构建地图检索视觉相似图像对,并根据立体图像对估计初始位姿。将该位姿作为先验,cuVSLAM 匹配局部地标进行定位。定位成功后,cuVSLAM 持续跟踪特征并执行地图优化,保持导航中机器人位姿准确。

我们在 Isaac ROS 中开发了离线地图创建工作流,从 ROS bag 构建地图,并提供 isaac_ros_visual_slam 与 isaac_ros_visual_global_localization 包实现定位。使用立体摄像头驱动、图像校正节点、occupancy 图服务器、cuVSLAM 与 cuVGL 节点,即可在 ROS2 中创建完整定位流程。

图 2. 机器人拿起苹果时的 cuVSLAM 特征跟踪

开始开发

- 从 HuggingFace 下载并试用 Isaac GR00T N1.6 开放模型。

- 使用 Isaac Lab 和 Newton 进行 RL 与策略训练,并在 Isaac Lab 中使用 COMPASS 生成导航合成数据。

- 使用 Isaac ROS 中发布的 CUDA-X 视觉映射与定位库:

- 从校正立体图像生成视觉与 occupancy 图。

- 启动 cuVSLAM 与 cuVGL 使用生成地图实现对机器人的定位。

订阅我们的新闻通讯,并在 LinkedIn、Instagram、X 和 Facebook 上关注 NVIDIA Robotics,以获取最新动态。您还可以查阅 NVIDIA 文档与 YouTube 频道,或加入 NVIDIA 开发者机器人论坛。若想开启机器人开发之旅,欢迎立即报名参加我们免费的 NVIDIA 机器人基础课程。

立即开始使用 NVIDIA Isaac 库与 AI 模型,开发物理 AI 系统。

了解更多相关技术,请关注 NVIDIA CES 2026。