新的 Mistral 3 开放模型系列为开发者和企业提供了卓越的准确性、高效的性能以及灵活的定制功能。该系列已针对 NVIDIA GB200 NVL72 进行优化,并支持从云端到边缘平台的广泛部署。

- 一个先进的大型稀疏多模态多语言混合专家(MoE)模型,总参数规模达6750亿。

- 另有一套小型、高密度的高性能模型系列,名为 Ministral 3,包含 3B、8B 和 14B 三种规模,每种规模均提供 Base、Instruct 和 Reasoning 三种版本,共计 9 个模型。

所有模型均在 NVIDIA Hopper GPU 上完成训练,现已可通过 Mistral AI 在 Hugging Face 平台上获取。开发者可根据需求从多种选项中选择,将这些模型部署于不同型号的 NVIDIA GPU 上,支持多种模型精度格式,并兼容主流开源框架(见表 1)。

| Mistral Large 3 | Ministral-3-14B | Ministral-3-8B | Ministral-3-3B | |

| 总参数 | 675B | 14B | 8B | 3B |

| 激活参数 | 41B | 14B | 8B | 3B |

| 上下文窗口 | 256K | 256K | 256K | 256K |

| 基础格式支持 | – | BF16 | BF16 | BF16 |

| Instruct 版本量化支持 | – | Q4_K_M, FP8, BF16 | Q4_K_M, FP8, BF16 | Q4_K_M, FP8, BF16 |

| 推理阶段支持格式 | Q4_K_M, NVFP4, FP8 | Q4_K_M, BF16 | Q4_K_M, BF16 | Q4_K_M, BF16 |

| 支持框架 | ||||

| vLLM | ✔ | ✔ | ✔ | ✔ |

| SGLang | ✔ | – | – | – |

| TensorRT-LLM | ✔ | – | – | – |

| Llama.cpp | – | ✔ | ✔ | ✔ |

| Ollama | – | ✔ | ✔ | ✔ |

| NVIDIA 硬件支持 | ||||

| GB200 NVL72 | ✔ | ✔ | ✔ | ✔ |

| Dynamo | ✔ | ✔ | ✔ | ✔ |

| DGX Spark | ✔ | ✔ | ✔ | ✔ |

| RTX | – | ✔ | ✔ | ✔ |

| Jetson | – | ✔ | ✔ | ✔ |

Mistral Large 3 基于 NVIDIA GB200 NVL72 实现卓越性能

NVIDIA 加速的 Mistral Large 3 借助专为大型先进 MoE 架构量身定制的全面优化堆栈,在 NVIDIA GB200 NVL72 平台上展现出卓越性能。图 1 展示了 Pareto 前沿在 GB200 NVL72 与 NVIDIA H200 之间的交互性能范围。

在生产级 AI 系统需兼顾卓越用户体验(UX)与经济高效扩展的背景下,GB200 相较于上一代 H200 性能提升达 10 倍,在每位用户每秒生成 40 个 token 的速率下,每秒处理能力可超过 50 万个 token/兆瓦(MW)。

这种代际收益体现在更优的用户体验、更低的每 token 成本,以及新模型更高的能效上。这些提升主要由推理优化堆栈的以下组件推动:

- NVIDIA TensorRT-LLM Wide Expert Parallelism(Wide-EP)提供经过优化的 MoE GroupGEMM 内核、专家分布与负载均衡机制,以及高效的专家调度策略,充分释放 NVL72 相干内存域的性能潜力。尤为值得关注的是,该 Wide-EP 功能集对大型 MoE 架构的多样性变化具备高度适应性。例如,Mistral Large 3 模型每层的专家数量为 128,约为 DeepSeek-R1 的一半,但仍能有效利用 NVIDIA NVLink 网络所具备的高带宽、低延迟和无阻塞通信优势。

- 在 SGLang、TensorRT-LLM 和 vLLM 的协同支持下,结合 NVFP4 低精度格式,实现了兼顾推理效率与模型精度的高效部署。

- Mistral Large 3 还依托 NVIDIA Dynamo,一种专为低延迟设计的分布式推理框架,对推理过程中的预填充和解码阶段进行速率匹配与任务分解,显著提升了长上下文工作负载的性能表现,例如在 8K/1K 的上下文配置下(如图 1 所示)。

与所有模型类似,即将推出的性能优化技术(例如采用多token预测(MTP)和EAGLE-3进行预测性解码)有望进一步提升模型表现,从而更好地发挥这一新模型的潜力。

NVFP4 量化

对于 Mistral Large 3,开发者可部署经过计算优化的 NVFP4 检查点,该检查点通过开源的 LLM 压缩器 库实现离线量化。借助 NVFP4 具备更高精度的 FP8 缩放系数以及更细粒度的块级缩放机制,能够有效控制量化误差,从而在保障模型准确性的同时,降低计算与内存开销。

该方案专为 MoE 权重设计,同时保持其他所有组件处于其原始检查点精度。由于 NVFP4 原生支持 Blackwell 架构,此变体可无缝部署于 GB200 NVL72 平台。NVFP4 FP8 的规模因子与细粒度块扩展机制有助于有效控制量化误差,降低计算与内存开销,同时将精度损失控制在较低水平。

开源推理

这些开源权重模型可与您选择的开源推理框架配合使用。 TensorRT-LLM 针对大型 MoE 模型进行了优化,可在 GB200 NVL72 系统上显著提升性能。如需快速上手,可使用预配置的 TensorRT-LLM Docker 容器。

NVIDIA 与 vLLM 展开合作,进一步扩展了对预测解码(EAGLE)、NVIDIA Blackwell 架构、模型分解以及扩展并行技术的内核集成支持。现在,您可以在 NVIDIA 云端 GPU 上部署基于 vLLM 的 Launchable 应用。如需了解服务化模型的示例代码及常见用例的 API 调用方式,可参考在 NVIDIA GPU 上运行 Mistral Large 3 675B Instruct 的实践指南。

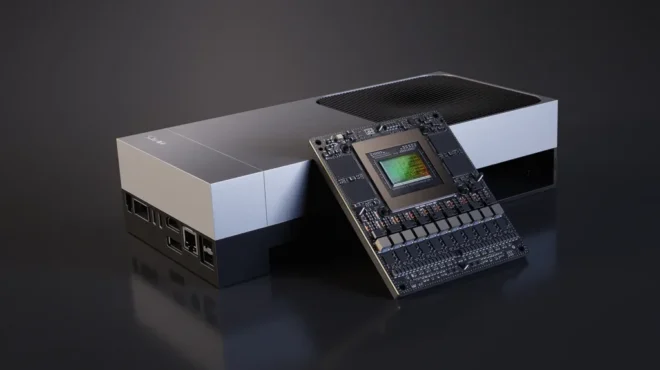

图 2 展示了 NVIDIA 构建平台中可用于部署 Mistral Large 3 和 Ministral 3 的 GPU 范围,您可以根据需求选择合适的 GPU 规格和配置。

NVIDIA 还与 SGLang 合作,实现了 Mistral Large 3,并集成了分解与预测性解码技术。更多详情请参阅 SGLang 文档。

Ministral 3 模型在速度、通用性和准确性方面表现出色

小型、高密度的高性能 Ministral 3 模型专为边缘部署设计,具备满足多样化需求的灵活性。该系列提供三种参数规模(3B、8B 和 14B),每种规模均包含基础、指令微调和推理优化三种版本。您可在 NVIDIA GeForce RTX AI PC、NVIDIA DGX Spark 以及 NVIDIA Jetson 等边缘计算平台上体验这些模型。

在本地开发时,您依然可以充分利用 NVIDIA 的加速能力。NVIDIA 与 Ollama 和 llama.cpp 深度合作,带来更高效的迭代速度、更低的延迟以及更强的数据隐私保护。在搭载 Ministral-3B 模型的 NVIDIA RTX 5090 D 上,推理速度可达每秒 385 个 tokens。立即开始使用 Llama.cpp 与 Ollama,体验流畅的本地 AI 开发。

对于 Ministral-3-3B-Instruct 模型,Jetson 开发者可利用 vLLM 容器 在 NVIDIA Jetson Thor 上,在单并发情况下实现每秒 52 个 tokens 的生成速度,在 8 并发时性能可提升至每秒 273 个 tokens。

使用 NVIDIA NIM 实现生产就绪型部署

Mistral Large 3 和 Ministral-14B-Instruct 现已可通过 NVIDIA API Catalog 及预览版 API 使用,帮助开发者快速上手,减少初始配置工作。不久之后,企业开发者还将能够通过可下载的 NVIDIA NIM 微服务,在任何 GPU 加速的基础设施上轻松完成部署。

开始使用开源 AI 进行构建

NVIDIA 加速的 Mistral 3 开放模型系列标志着跨大西洋人工智能在开源社区中迈出的重要一步。该系列兼具适用于大规模 MoE 架构和面向边缘设备的高效密集型 Transformer 模型,灵活满足开发者在不同开发阶段的多样化需求。

借助 NVIDIA 优化的性能、NVFP4 等先进量化技术以及广泛的框架支持,开发者能够实现从云端到边缘端的高效性与可扩展性。您可以先从 Hugging Face 下载 Mistral 3 模型,或访问 build.nvidia.com/mistralai 免费试用并部署。